Acercamiento a algunas estructuras de la "Montaña mistica". (NASA/ESA) (Click for zoom)

Friday, April 23, 2010

Celebrando 20 años del Telescopio Espacial Hubble

Acercamiento a algunas estructuras de la "Montaña mistica". (NASA/ESA) (Click for zoom)

Monday, April 19, 2010

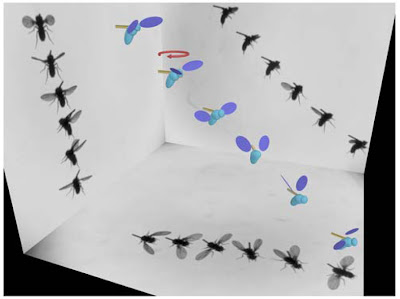

Vuelo de insectos: La capacidad de estabilización de la mosca de fruta.

Ristroph [1] y colegas han estudiado en detalle como las moscas de fruta se recuperan de perturbaciones durante el vuelo y proponen un mecanismo que explica la auto-estabilización que utilizan.

Friday, April 9, 2010

Arte de la ciencia exacta

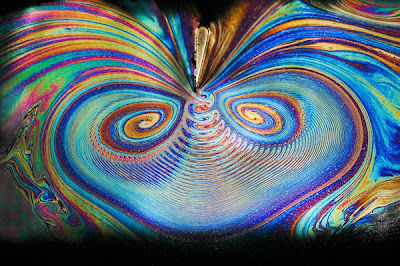

Las ondulaciones producidas en una delgada capa de jabón asemejan el flujo de aire de algún abanico de mano, esta imagen de un equipo de investigación de la Universidad Técnica de Dinamarca fue creada usando un ventilador sobre una delgada capa lo que produjo esta admirable forma.

Burbujas producidas por pulsos laser (2009)

Un equipo de investigadores de la Universidad Técnica de Nanyang en Singapur fotografiaron 25 burbujas de manera simultánea que fueron producidas usando pulsos láser hacia un líquido. En este arreglo –imagen tomada seis microsegundos después del impacto del láser- la presión de aire en las burbujas centrales es casi la misma que del flujo que la rodea. Esto permite a las burbujas aumentar su tamaño antes de colapsar. Sin embargo, las burbujas externas colapsan rápidamente debido a la alta presión del flujo exterior. Nótese que las burbujas en los bordes empiezan colapsar, mientras que las del centro casi han alcanzado su mayor tamaño.

Inestabilidad Kevin-Helmholtz con caracteristica fractal (2008)

Investigadores de la Universidad de Toulouse y la Universidad de San Andres, en Francia y en el Reino Unido, respectivamente, han producido una imagen de instabilidades de Kevin-Helmholtz con características fractales. La autosemejanza en las escalas puede verse en la serie de figuras (a)-(e) las cuales exponen la ruta hacia la turbulencia a través de un proceso fractal.

Acuario de microfluidos (2007)

Investigadores de la Universidad de California, E.U.A., han creado un mapa visual de dos flujos de fluido en un micro-canal (altura=100 micro-metros, ancho=2 mm) de forma de diamante. En esta imagen se muestran la influencia de las propiedades del fluido en la morfología del microflujo. Con ello se pretende investigar fenómenos como la mezcla, coalición, humedad, lubricación, etc. Se les han dado nombres de animales acuáticos a las figuras para una sencilla identificacion, por lo que se produce un “acuario de microfluidos”.

Caminando sobre agua (2003)

Investigadores del Instituto de Tecnología de Massachussets han logrado visualizar el patrón de flujo que produce un insecto al caminar sobre el agua. Este insecto, -muy común en ríos, lagos- es soportado por la tensión superficial generada por la curvatura de la superficie. Su cuerpo y sus patas están cubiertos de miles de pequeños cabellos que permiten a sus extremidades el repeler la humedad. Además de lograr desplazarse al poner en movimiento sus patas centrales y que en el proceso transfieren momentum al fluido a través de vortices.

Video concursante.

Tornados en microcanales (Arizona State University).

Cuspides No-Newtonianas (UNAM)

Monday, July 20, 2009

En busca de soluciones a la crisis energética: Los reactores nucleares híbridos

Con las reservas naturales de combustibles fósiles agotándose, los efectos que este tipo de combustibles tienen en el calentamiento global, el incremento en los costos y el crecimiento de la demanda mundial de energía a una tasa sin precedente, la era de los combustibles fósiles esta llegando a su fin. Existe una creciente urgencia global en generar energía libre de emisiones de carbón (CO2) y tener una fuente que garantice el suministro energético mundial y minimice el impacto ambiental.

La energía nuclear ha renacido como una alternativa ante esta crisis energética, aunque es indudable que no cuenta con aceptación en gran parte de la sociedad principalmente por cuestiones de seguridad y de manejo de los desechos radioactivos, diferentes avances científicos y tecnológicos estarían a punto de cambiar esta percepción.

Existen 2 formas de extraer energía de un núcleo: fisión y fusión. La fisión nuclear se logra rompiendo núcleos muy pesados como ciertos isótopos del uranio y el plutonio, para ello se necesitan neutrones que sean absorbidos por el núcleo lo que crea una configuración muy inestable dando lugar al rompimiento del núcleo (fisión nuclear) y liberando grandes cantidades de energía. Para generar energía nuclear sustentable se necesita un flujo constante de neutrones que genere constantemente el rompimiento de los núcleos, esto se consigue generando una reacción en cadena en donde el núcleo al romperse, también emite neutrones que son utilizados por otro núcleo y así sucesivamente.

Inversamente, la fusión nuclear se lleva a cabo cuando núcleos ligeros (usualmente se utilizan los isótopos del hidrogeno: deuterio y tritio) llegan a juntarse liberando energía y produciendo gran cantidad de neutrones. Este es el proceso que ocurre naturalmente en las estrellas, donde las condiciones de presión y temperatura son las adecuadas.

Los reactores nucleares actuales producen energía por fisión nuclear, con la desventaja de que también producen desechos radioactivos que deben ser almacenados hasta por cientos o incluso miles de años. Regularmente los desechos nucleares son almacenados en lugares especiales, pero también pueden ser procesados si son sometidos al adecuado flujo de neutrones, pues pueden ser transmutados en elementos de vida mas corta o incluso en elementos estables. La fisión nuclear produce aproximadamente 15 veces mas energía que la fusión nuclear, sin embargo, la fusión nuclear no produce desechos nucleares, pero las condiciones de confinamiento requeridas son muy difíciles de controlar y no existe aun producción comercial de energía por este método. Los avances tecnológicos y científicos requeridos para la explotación comercial de la energía por fusión nuclear se estima que tardaran alrededor de 20 a 50 años en llegar.

Los reactores híbridos de fusión-fisión, fueron concebidos para capitalizar las ventajas y minimizar las desventajas de ambos procesos. El proceso de fisión nuclear genera mucha energía pero necesita un flujo constante de neutrones y produce desechos radioactivos de muy larga vida. La fusión nuclear genera, con la actual tecnología, menos energía de la que consume pero produce muchos neutrones. La idea es construir una maquina hibrida, el centro de la cual consistiría de un reactor de fusión rodeado por desechos radioactivos que funcionarían como el material fisionable, todo dentro de un reactor de fisión. El reactor de fusión generaría los neutrones que son utilizados para mantener la fisión activa, el reactor de fisión produciría la energía necesaria para el funcionamiento del reactor de fusión, quitando la necesidad de mantener la reacción en cadena y en consecuencia teniendo más control sobre la generación de energía, lo que se traduce en más seguridad. Este tipo de reactor podría generar electricidad, producir energía como cualquier reactor de fisión convencional y proveer una forma de transmutar los desechos nucleares de vida muy larga en materiales no radioactivos o desechos con vidas mucho mas cortas.

Hoy en día existen 3 diseños de reactores híbridos, la parte critica se basa en el funcionamiento del reactor de fusión, ya que se necesita concentrar el combustible en una región muy confinada del espacio, para ello, 2 de los diseños se basan en confinamiento por campos magnéticos. El instituto tecnológico de Georgia propone un diseño basado en un el campo magnético anular (tokamak) en el cual el material fisionable (desechos nucleares de fisión) esta dentro de los magnetos del tokamak, rodeando el plasma de fusión.

En el concepto propuesto por la universidad de Texas, difiere en que el material fisionable se encuentra afuera del campo magnético.

En el laboratorio Nacional de Lawrence Livermore, se investiga el confinamiento inercial, el cual consiste en generar fusión nuclear enfocando láseres en una pequeña región del espacio donde se encuentra el combustible. En ambos casos, la fusión nuclear crearía neutrones que causarían fisión en el material fisionable. El proceso reduciría los desechos radioactivos hasta en un 99% a los generados por un reactor de fisión convencional, además de que al quemar estos desechos también se produciría energía.

Los reactores híbridos generarían una expansión mundial de la energía nuclear en forma segura y sustentable. Los científicos esperan hacer de la energía nuclear una alternativa más viable mientras se desarrollan otras formas de producción de energía como la energía solar, eólica o fusión pura.

Con el apoyo a la ciencia y la tecnología los gobiernos del mundo pueden resolver muchos de los problemas de la sociedad y salir de situaciones críticas que permitan una convivencia sustentable de toda la humanidad con nuestro entorno.

Referencias

M. Kotschenreuther, et al., Fusion-fission transmutation Scheme-Efficent destruction of nuclear waste, Fusion Enginnering and Design, 84 (2009) 83-88.

http://ptonline.aip.org/journals/doc/PHTOAD-ft/vol_62/iss_7/24_1.shtml

http://www.nature.com/nphys/journal/v5/n6/full/nphys1288.html

Tuesday, April 21, 2009

Simulación de fluidos usando dinámica molecular

Por Joel Jiménez

Un fluido es una sustancia que esta compuesta por átomos y moléculas. Las complejas estructuras que forman los fluidos al fluir emanan del movimiento colectivo de sus elementos constituyentes. La mecánica de fluidos es la rama de la mecánica que estudia el movimiento de los fluidos (gases y líquidos), así como las fuerzas que lo provocan. Además, se encarga de investigar la interacción del flujo de fluidos con su entorno. La mecánica de fluidos esta basada en la hipótesis del medio continuo, en esta se considera que el fluido es continuo a lo largo del espacio que ocupa, ignorando por tanto su estructura molecular y discontinuidades. Basado en esta hipótesis se desarrolla un conjunto de ecuaciones matemáticas, que provienen de principios básicos como conservación de masa, momentum y energía. El modelo matemático que gobierna el movimiento de los fluidos son las llamadas ecuaciones de Navier-Stokes.

Estela detrás de una placa plana en un flujo de agua (ONERA)

La hipótesis del continuo resulta inválida en sistemas donde existen escalas de longitud muy pequeñas, por ejemplo en escalas de micrómetros ó nanómetros. Las áreas de estudio a estas escalas son llamadas mirofluidica (sistemas como canales y tubos de longitudes menores a un milímetro) y nanofluidica (sistemas con longitudes menores a un micrón); como referencia el espesor de un cabello humano es de 100 micrones. Actualmente se dedica un gran esfuerzo en la ciencia y tecnología hacia el diseño y desarrollo de dispositivos a estas escalas. En estas escalas la mayoría de las simulaciones de fluidos son hechas por computadora. Las computadoras proveen una capacidad muy extensa en cálculos numéricos.

El área dedicada al estudio de movimiento de átomos y moléculas es conocida como Dinámica Molecular (DM). En la DM los átomos y moléculas interactúan por ciertos periodos de tiempo, la modelación incluye el uso de las representaciones matemáticas de la física (por ejemplo, leyes de movimiento clásicas) dando lugar al movimiento de los átomos. Cuando se incluyen un gran número de átomos la(s) computadora(s) enfrentan grandes dificultades, sin embargo con el constante avance en la computación las simulaciones moleculares son cada vez más rápidas y complejas. Richards y Krauss [1], han mostrado la extraordinaria capacidad de la dinámica molecular en simular un flujo a gran escala, ellos utilizaron 9 mil millones de átomos (cobre y aluminio a una temperatura de 2000 K) en una geometría cuasi-bidimensional, en ella se estudio la llamada inestabilidad de Kevin-Helmholtz. La inestabilidad de Kevin-Helmholtz ocurre cuando existe una velocidad de corte entre la interfase de dos fluidos, esto resulta en una estructura compleja de vórtices que da lugar a fenómenos de mezcla. Cabe agregar que aun cuando la dinámica molecular es muy útil, el uso de recursos es prohibitivo en simular problemas a escala humana, además de hacer difícil el trazar las relaciones entre los diferentes parámetros del problema.

[1] Atoms in the Surf: Molecular Dynamics Simulation of the Kelvin-Helmholtz Instability using 9 Billion Atoms, http://arxiv.org/abs/0810.3037

Video:

Simulación e inestabilidad Kevin-Helmholtz

Friday, October 3, 2008

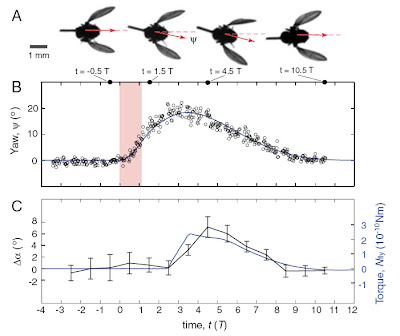

El Gran Colisionador de Hadrones (LHC)

El LHC es el último y mas poderoso acelerador de partículas que se ha construido en el mundo, es un proyecto internacional de investigación en física de partículas basado en el laboratorio europeo CERN que se encuentra en Ginebra, Suiza. Aquí, físicos e ingenieros de 111 paises crearon y llevan a cabo actualmente el experimento científico más grande realizado en la historia de la humanidad.

El LHC es el último y mas poderoso acelerador de partículas que se ha construido en el mundo, es un proyecto internacional de investigación en física de partículas basado en el laboratorio europeo CERN que se encuentra en Ginebra, Suiza. Aquí, físicos e ingenieros de 111 paises crearon y llevan a cabo actualmente el experimento científico más grande realizado en la historia de la humanidad.

Este gigantesco instrumento científico es un acelerador de partículas localizado 100 metros bajo tierra en la frontera entre Suiza y Francia, en donde 2 haces de partículas subatómicas llamadas "Hadrones" (los cuales en este caso seran protones o iones de Plomo) viajarán en direcciones opuestas dentro del acelerador, ganando energía con cada vuelta hasta alcanzar la energía máxima y chocar de frente, generando partículas jamas vistas que los científicos analizaran utilizando los diferentes detectores construidos y dedicados especialmente para el LHC.

Con sus 27 kilometros de circunferencia, el LHC es la máquina más grande y poderosa creada por el hombre; a su máxima potencia, los protones viajarán a 99.99% de la velocidad de la luz generando alrededor de 600 millones de colisiones por segundo a 14 TeV (tera-electronvoltios). En el instante en que los protones choquen de frente, se alcanzarán temperaturas 100,000 veces más altas que la del centro del sol. En contraste, el sistema cryogénico consiste de Helio superfluido que circula alrededor del anillo del acelerador, el cual lo mantiene a una temperatura de -271.3 °C, haciendolo aún más frio que el espacio exterior. Para evitar las colisiones con partículas de gas en el interior del acelerador, los haces de partículas viajarán en ultra alto vacio (tan vacio o más que el espacio interplanetario). Para detectar y registrar esta gran cantidad de eventos se han construido los detectores más grandes y sofisticados asi como el sistema de supercomputadoras más poderoso en el mundo.

Existen muchas teorias acerca de cuales serán los resultados de estas colisiones. El LHC ha sido construido para ayudar a encontrar respuestas a algunas de las preguntas fundamentales y aún sin resolver en la física de partículas. El conocimiento de las partículas fundamentales de las cuales esta hecho el universo y sus interacciones, esta encapsulado en lo que es conocido como el “Modelo Estándar” de la física de partículas. Sin embargo existen vacios en la teoria, los cuales se pretenden llenar con los datos experimentales arrojados por el LHC, solo estos datos pueden ampliar nuestro conocimiento e inclinar la balanza en favor de aquellos que buscan confirmación del conocimiento establecido o de los que sueñan desafiarlo.

¿Qué pasaría si algo sale mal en el LHC?, como se ha mencionado, este alcanzará energías jamás producidas por el hombre, ¿hay probabilidades de lo que se pretende crear con esta máquina nos destruya? Existen muchas dudas acerca de lo que descubrirá el LHC, por eso mismo, algunos miembros de la comunidad científica han demandado judicialmente al proyecto para que se haga una valoracion de riesgos [1]. El proyecto del LHC ha sido sometido y ha aprobado rigurosos exámenes de seguridad y confiabilidad.

El punto fundamental es que aunque el LHC alcanzará las más altas energías producidas en un acelerador de partículas, energías de esta magnitud o mayores, se producen a menudo en el espacio exterior, por ejemplo en los rayos cósmicos. Asi lo que se produzca en el LHC, es algo que la naturaleza ha estado produciendo continuamente. Además la máxima energía producida esta restringida a un pequeño volumen al interior de los detectores, los cuales estan diseñados para detectar, interactuar, localizar y detener todo lo que se produzca (a excepción de los neutrinos), ya que capturar todas las diferentes formas de energía es escencial para identificar que tipo de partículas se han producido. El peligro principal es para el acelerador mismo, la mayor preocupación es que la energía pueda ser deflectada hacia las paredes, la linea del haz o los imanes del LHC, lo que causaría grandes destrozos. Por ello, el LHC esta equipado con varios sistemas de seguridad automáticos los cuales monitorean todas las partes críticas del acelerador y si algo no esperado en el funcionamiento sucede se cortará la energía automaticamente y se desviará el haz de partículas hacia un tunel dispuesto para disipar la energía en forma segura.

Algunas preguntas sin respuesta…

Los científicos creen que nuestro unvierso se originó a partir de una explosión inimaginablemente violenta a la que se le conoce como “Big Bang”, a partir de ahi, el unvierso se ha ido enfriando y volviendo menos energético. Se piensa que muy temprano en el proceso de enfriamiento, la materia y las fuerzas que forman nuestro universo se condensaron a partir de esta bola de energía, sin embargo no se entiende cómo y por qué se desarrollo el universo de la manera que lo vemos ahora. Las colisiones que se produciran en el LHC recrearan en microescala las energías y las condiciones que existieron en el universo millonésimas de segundo después del Big Bang, dando respuesta a algunas de las preguntas fundamentales y mas audaces de la ciencia.

El bosón de Higgs y el misterio de la masa.

Sabemos que algunas partículas como el electrón o los quarks, tienen masa, sin embargo, otras como los fotones no tienen, la pregunta es entonces ¿qué es la masa?, o ¿por qué algunas particulas tienen masa y otras no? La respuesta mas aceptada propone la existencia de un campo (el campo de Higgs) el cual permea todo el universo e interactua con solo algunas partículas dandoles masa. Si la teoria es acertada el campo de Higgs se debe revelar como una partícula, el bosón de Higgs, la cual deberia ser producida y detectada a las energias del LHC.

Las partículas super-simétricas y el universo invisible.

Todo lo que vemos en el universo, desde un grano de arena hasta las estrellas y galaxias, pasando por los seres vivos, estamos hechos de materia, el problema es que juntando toda la materia en el unvierso solo llegamos al 4% del mismo, ¡No sabemos qué es o de qué esta hecho el otro 96%! Se cree que la materia obscura y la energía obscura forman esta parte desconocida, sin embargo son muy difíciles de detectar y estudiar. La teoria de la supersimetria sugiere que todas las partículas tienen compañeros supersimétricos que aún no han sido detectados, pero si existen, el LHC deberia encontrarlos. Una possible explicación es que la materia obscura consista de partículas supersimétricas.

La antimateria.

Al principio de nuestro universo, el Big Bang debio haber creado cantidades iguales de materia y de antimateria, pero cuando materia y antimateria se juntan, se aniquilan produciendo energía. Sin embargo, en algun momento, de alguna manera una pequeña fracción de materia debió haber sobrevivido para formar nuestro unvierso como lo vemos hoy, aunque se ha detectado la antimateria y se sabe que algunas partículas decaen en antipartículas, no se entiende porque la naturaleza parece tener preferencia hacia la materia sobre la antimateria. Uno de los experimentos del LHC esta dedicado a encontrar las diferencias en el decaimiento de las partículas producidas y determinar que paso o donde esta la antimateria.

El quark-gluón plasma y los secretos del Big Bang.

La materia como la conocemos esta formada por átomos, los cuales contienen nucleos compuestos por protones y neutrones, los cuales a su vez, estan hechos de quarks que se mantienen unidos gracias a los gluones. Esta interaccion es muy fuerte y hasta ahora no se han encontrado quarks aislados. Sin embargo se cree que durante los primeros microsegundos despues del Big Bang, el unverso pudo haber contenido una muy caliente y densa mezcla de quarks y gluones a la que se le llama el quark-gluón plasma. Cuando nucleos de Plomo colisionen en el LHC, se daran las condiciones que recrearán ese temprano estado en la evolución del unvierso, proporcionando información muy importante acerca de este estado de la materia.

Las extra-dimensiones del espacio y los universos ocultos.

Einstein mostro que las tres dimensiones espaciales y el tiempo estan relacionados creando un universo de 4 dimensiones. En la actualidad muchos físicos piensan que el universo tiene más dimensiones, por ejemplo la teoria de cuerdas sugiere que existen dimensiones espaciales adicionales a las observadas. La fuerza de gravedad no se ajusta de una manera cómoda a las descripciones de las demas interacciones del unvierso, es ademas mucho más débil que las otras fuerzas fundamentales. Una posible explicación es que nuestro universo sea parte de una realidad multi-dimensional más grande y que la gravedad pueda influir en las otras dimensiones, lo que la haria parecer mas débil que las demas interacciones. El LHC puede permitirnos obtener evidencia de esas extradimensiones, por ejemplo, con la producción de hoyos negros miniatura los cuales entrarian y saldrian de nuestro unvierso en una pequeña fracción de segundo.

Todas estas preguntas y posibles respuestas hacen que el LHC sea esperado con gran entusiasmo por la comunidad científica internacional, los resultados que arroje pueden ser totalmente inesperados, ¡pero eso es parte del proyecto! Cabe señalar que el LHC no creará un nuevo universo, ya que aunque pretende recrear a microescala las condiciones que se dieron poco despues de que se inicio el Big Bang, no poseé la energía para crear las condiciones del Big Bang mismo. De acuerdo a los reportes de seguridad [2], no existe la posibilidad de que hoyos negros microscópicos producidos en las colisiones se traguen la tierra, o que se creén perturbaciones que destruyan nuestro universo. Los investigadores esperan confirmar predicciones hechas a partir de teorias y experimentos previos. Sin embargo, parte de la excitación del proyecto es que pueden descubrir hechos totalmente nuevos acerca de la materia y del origen del universo de los cuales pronto seremos testigos.

REFERENCIAS

http://public.web.cern.ch/public/en/LHC/

[1] http://www.lhcdefense.org/

[2] http://lsag.web.cern.ch/lsag/LSAG-Report.pdf

Video:

LHC (CERN TV) y El LHC rap

Sunday, September 28, 2008

La Política y el uso del Miedo

La política es una actividad humana con el fin a gobernar o dirigir la acción del estado en beneficio de la sociedad. Esta es una actividad orientada, ideológicamente, a la toma de decisiones de un grupo para el logro de unos objetivos. La ideología política esta en general compuesta de dos propiedades, la económica y la social. Por lo que su clasificación entra en cierto espectro que depende de la afinidad a estas dos propiedades. Por ejemplo, pudiera clasificarse en totalitarismo, conservadurismo, socialismo o liberalismo.

En una nación democrática, la organización del Estado o gobierno, es elegida mediante el voto de la sociedad, y con ello cierto grupo o individuo político obtendrá legitimidad a representarlo por la obtención mayoritaria del voto. Así, la intención del voto del individuo (influenciada por su ideología política), es muy importante por grupos políticos diversos. Por ello es importante para los grupos políticos la influencia que pudieran tener en malear esta intención (que es cada día mas evidente en el uso mediático de la información con fines políticos), pero es aun de mas importancia que el ciudadano tenga conocimiento y no dar cabida a artimañas inapropiadas.

Una persona puede sentirse afín a cierta ideología, y en base a ella demuestra una actitud hacia ciertos temas sociales, como el aborto, inmigración, penas capitales, libertad de expresión, seguridad social, etc. La actitud individual a estos temas siempre se ha relacionado a su estatus económico, familiar, de amistad y educación.

La investigación de Oxley, D. y colegas [1] sugiere que las posturas políticas pudieran tener bases biológicas. Esto es, que hay variaciones en sus posturas al someter a los individuos a estrés físico. Ellos tomaron un grupo de participantes con fuertes creencias políticas, individuos con una medible baja sensitividad hacia ruidos abruptos e imágenes intimidantes eran mas afines a políticas como: inmigración liberal, pacifismo, control de armas, mientras que individuos con una medible mayor reacción fisiológica al mismo estimulo fueron mas afines a favor de la defensa del gasto económico, pena capital, patriotismo y políticas de guerra.

La investigación conducida indica que las respuestas del individuo esta correlacionada en que la persona fuera liberal o conservadora socialmente hablando. Los métodos empleados fue dar a los participantes dos pruebas y medir su respuesta fisiológica a la intimidación. Primeramente se utilizo equipo para medir su conductancia de la piel, la cual se sabe aumenta con el estrés emocional en respuesta al aumento de su humedad. A estos se les mostraron imágenes fuertes, como personas ensangrentadas. La otra medida se dirigió al parpadeo involuntario a eventos de sobresalto, como ruido abrupto muy fuerte.

Los grupos se dividieron en dos, en uno se encontraban aquellos con interés en proteger la “unidad social”, dentro de este grupo están aquellos que soportan fines como, pena de muerte, actos patrióticos, obediencia, verdad bíblica. Y a su vez se oponen al pacifismo, inmigración, control de armas, sexo premarital, boda homosexual, derechos al aborto y pornografía. El otro grupo eran participantes con menor interés de la “unidad social”.

En la primera grafica (izq.) se muestra el resultado de la medición de la conductividad, los participantes que mostraban mayor interés en proteger la “unidad social” se distinguieron por mostrar un incremento (en azul) en la conductancia cuando el estimulo de intimidación se les presentaba. Aquellos que presentaban un menor interés en la “unidad social” se vieron casi no afectados. En la segunda grafica (der.) se muestra el resultado del estudio del parpadeo al estimulo de sobresalto, similarmente a las mediciones previas mostraron mayor sensibilidad en individuos que apoyan las políticas de protección de la unidad social (en azul).

Fig.1. Cambios en la conductancia de la piel al exponer a imágenes intimidatorias (izq). Cambios en la media del parpadeo en respuesta a sonido abrupto de individuos afines a políticas sociales de protección (der.). Ref. [1]

Como conclusión esta investigación sugiere que la afinidad política varía con la exposición a intimidación fisiológica, y que se relaciona con la experiencia y procesamiento de estas amenazas ambientales. Con esto, se presenta como una posible explicación al hecho de falta de maleabilidad en creencias a individuos con fuerte convicción política.

Referencia:

[1] Oxley, D. R., Smith, K. B., Alford, J. R.,

The Shock doctrine (video):

Sunday, September 7, 2008

Los Huracanes y el aumento de su fuerza

Un ciclón tropical es caracterizado por una baja presión en su centro y numerosas tormentas eléctricas que producen vientos muy fuertes y una gran cantidad de lluvia. De acuerdo a su localización y fuerza, los ciclones tropicales suelen ser nombrados también como: Huracán, tifón, depresión tropical o simplemente ciclón. Es sabido que estos forman parte del sistema de circulación atmosférica que permite el movimiento del a calor del Ecuador a mayores latitudes. La temporada en que los huracanes tienen su máxima actividad es al final del verano, cuando la temperatura superficial de los océanos es más cálida

Un ciclón tropical es caracterizado por una baja presión en su centro y numerosas tormentas eléctricas que producen vientos muy fuertes y una gran cantidad de lluvia. De acuerdo a su localización y fuerza, los ciclones tropicales suelen ser nombrados también como: Huracán, tifón, depresión tropical o simplemente ciclón. Es sabido que estos forman parte del sistema de circulación atmosférica que permite el movimiento del a calor del Ecuador a mayores latitudes. La temporada en que los huracanes tienen su máxima actividad es al final del verano, cuando la temperatura superficial de los océanos es más cálida

Este año la temporada de huracanes parece ser más agresiva que en tiempos anteriores, científicos han presentado evidencia firme que muestra que el calentamiento global ha influido en el incremento de la intensidad de las tormentas extremas a nivel global.

Argumentos teóricos y simulaciones computacionales indican que los vientos de los ciclones tropicales aumentan al incrementar la temperatura oceánica. Elsner J., Kossin J. y Jagger T. [1], investigadores de la Universidad de Florida y la Universidad de Wisconsin-Madison han presentado un estudio que concuerda con la hipótesis que el calentamiento global contribuye con el incremento en la intensidad de los ciclones. Este estudio utiliza imágenes satelitales para el diagnostico de los vientos de 2,097 ciclones tropicales en el periodo de 1981-2006. Fig. 1(a) muestra la velocidad máxima del viento que se presento a dado año, y el número de ciclones se muestra en pequeños números sobre el eje de los años. Una tendencia de aumento se muestra en la velocidad máxima, aunque no parece haber un aumento en frecuencia. El análisis estadístico arroja que los incrementos son mayores para ciclones al Norte del Atlántico (Incluye el Océano Atlántico, el Mar Caribe y el Golfo de México). Por lo tanto, no hay un significante aumento en el numero de ciclones, sin embargo se encontró que si existe un aumento notable en la fuerza en que se presentan, por lo que hubo un mayor numero de tormentas que excedieron los 210 km/hr (Categoría 4 y 5, en la escala Zafiro-Simpson).

Figura 1. Análisis de los datos de imagenes satelitales sobre la macima velocidad en la vida de los ciclones tropicales. Lineas de tendencia para la media, 0.75 cuantil, 1.5 veces el rango del intercuartil. [1]

El aumento de las temperaturas oceánicas es la causa principal en la tendencia que los ciclones sean cada vez más fuertes. En promedio 13 ciclones se observan por año. El estudio estima que un aumento de un grado centígrado (1°C) en la superficie-del-mar puede resultar en un incremento del 31% en la frecuencia global de huracanes de categoría 4 a 5: de 13 a 17.

Referencias:

[1] Elsner J., Kossin J. and Jagger T., The increasing intensity of the strongest tropical cyclones, Nature, vol. 455, Sept. 2008.

Tuesday, July 22, 2008

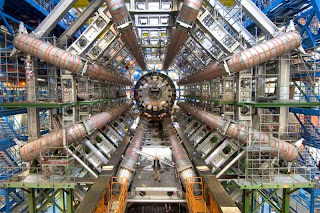

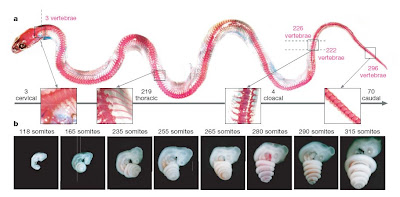

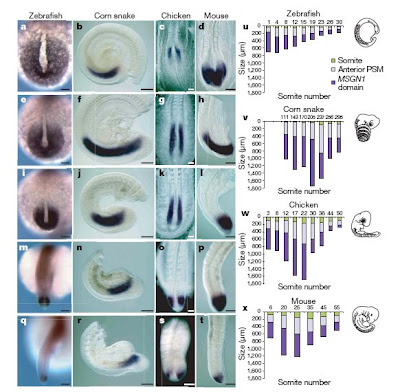

Desarrollo vertebral en animales

La evolución ha producido una amplia diversidad en las formas corporales en los seres vivos de acuerdo a su estilo de vida. La forma corporal de los animales esta relacionada con su estructura de huesos, en especial con el número de vértebras que posee. Cabe mencionar que se denomina vértebra a cada uno de los huesos que conforman la columna vertebral. En algunos animales el número de vértebras ha ido al extremo, por ejemplo en serpientes en general tienen más de 300 que resulta impresionante al compararse con los 33 del humano.

La evolución ha producido una amplia diversidad en las formas corporales en los seres vivos de acuerdo a su estilo de vida. La forma corporal de los animales esta relacionada con su estructura de huesos, en especial con el número de vértebras que posee. Cabe mencionar que se denomina vértebra a cada uno de los huesos que conforman la columna vertebral. En algunos animales el número de vértebras ha ido al extremo, por ejemplo en serpientes en general tienen más de 300 que resulta impresionante al compararse con los 33 del humano.

Figure 1. Somito-genesis, a) Somitas, segmentos regulares embrionicos, de los cuales algunos huesos (incluyendo vértebras) se desarrollan en vertebrados por un modelo reloj-frente de onda. b) En serpientes esta formación es mucho mas rápida, comparado con animales de cuerpos mas cortos. (Vonk F. J. y Richardson M. K., [1]).

Gómez, et al. [2], han publicado recientemente un estudio sobre el desarrollo vertebral a nivel embrionario en serpientes, peces, ratones y pollos. Su estudio corrobora la existencia de un “reloj” que regula el desarrollo de divisiones en el arreglo de vértebras, así en las serpientes este “reloj” tendría un tic-tac acelerado (relativo a la razón de crecimiento) en comparación con otras especies. Asumiendo que una somita es formada durante cada oscilación de este reloj, se puede deducir que el periodo de las oscilaciones al contar la razón de formación de somitas en embriones. En la serpiente de maíz (Elaphe guttata guttata), el promedio de formación de somitas es de un par cada 100 minutos, comparado a las razones de un par cada 10, 90 y 120 min., en pez tipo zebra, pollo y ratón, respectivamente. Otro aspecto interesante es que durante esta somito-génesis el tamaño se incrementa al inicio, pero gradualmente se contrae hasta que se agota, lo que termina con la formaron de somitas. Ver Fig. 2 y Fig. 3.

Figura 2. Formación vertebral y somito-genesis de la serpiente de maíz. a) vértebras, b) tiempo de desarrollo, (Gomez, et al., [2]).

Figura 3. Dinámica del PSM en pez zebra, serpiente de maíz, pollo y ratón, a-t, vistas dorsales y laterales. u-x, gráficas de la evolución de la formación de somitas en estas especies, (Gomez, et al., [2]).

Este mecanismo de reloj-frente de onda al parecer es muy importante para la selección natural, ya que cambios en el número de vértebras en los seres vivos puede afectar de manera importante a su salud y desempeño. Por ejemplo, el número de vértebras en animales puede influenciar su velocidad en locomoción.

Referencias:

[1] Vonk F. J. and Richardson M. K., Serpent clocks tick faster, Nature, vol.454, 17 July 2008.

[2] Gomez, C., Ozbudak, E. M., Wunderlich, J., Baumann, D., Lewis, J., Pourquie, O., Control of segment number in vertebrae embryos, Nature, vol. 454, 17 July 2008.

Video (Desarrollo embrionario Pez zebra):

Monday, July 7, 2008

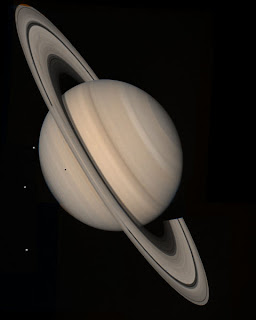

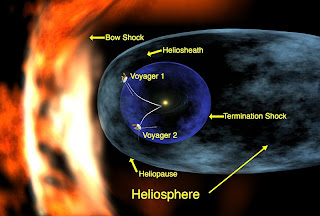

Las sondas espaciales Viajero 1 y 2

Las misiones Viajero o “Voyager” de la Agencia Espacial Norteamericana (N.A.S.A.), han transformado la visión de la humanidad del Sistema Solar. El viajero 1 o “Voyager 1”, es una sonda espacial lanzada para explorar los limites del sistema solar y mas allá. Lanzada en septiembre de 1977 aun sigue operacional. Este viajero ha visitado Júpiter y Saturno, siendo la primera sonda espacial en mostrar imágenes de las lunas de estos planetas. Hasta mayo del 2008, el viajero 1 esta a una distancia de unos 15.89x109 km, o 106.26 Unidades Astronómicas (UA) del Sol. El viajero 2 o “Voyager 2”, fue lanzada en Agosto de 1977, un poco antes de viajero 1. Esto debido a fallas de viajero 2, pero que sirvieron como aprendizaje y permitió que viajero 1 despegara satisfactoriamente. La trayectoria de viajero 1 fue mas corta, con lo que se acerco antes a Júpiter en Marzo de 1979. Posteriormente fue a Saturno en Noviembre de 1980. Viajero 2 paso por Júpiter (en julio de 1979) y Saturno (en Agosto de 1981) también.

Las misiones Viajero o “Voyager” de la Agencia Espacial Norteamericana (N.A.S.A.), han transformado la visión de la humanidad del Sistema Solar. El viajero 1 o “Voyager 1”, es una sonda espacial lanzada para explorar los limites del sistema solar y mas allá. Lanzada en septiembre de 1977 aun sigue operacional. Este viajero ha visitado Júpiter y Saturno, siendo la primera sonda espacial en mostrar imágenes de las lunas de estos planetas. Hasta mayo del 2008, el viajero 1 esta a una distancia de unos 15.89x109 km, o 106.26 Unidades Astronómicas (UA) del Sol. El viajero 2 o “Voyager 2”, fue lanzada en Agosto de 1977, un poco antes de viajero 1. Esto debido a fallas de viajero 2, pero que sirvieron como aprendizaje y permitió que viajero 1 despegara satisfactoriamente. La trayectoria de viajero 1 fue mas corta, con lo que se acerco antes a Júpiter en Marzo de 1979. Posteriormente fue a Saturno en Noviembre de 1980. Viajero 2 paso por Júpiter (en julio de 1979) y Saturno (en Agosto de 1981) también.

Estas misiones espaciales han sido muy exitosas, han tomado imágenes de alta resolución de atmósferas, satélites, anillos, las lunas de Júpiter y Saturno, además de sus Magnetosferas. Actualmente viajero 2 ha seguido al viajero 1 a una región mas allá del alcance del viento solar, donde la influencia del espacio interestelar es mucho mayor, con ello abre una nueva era de exploración.

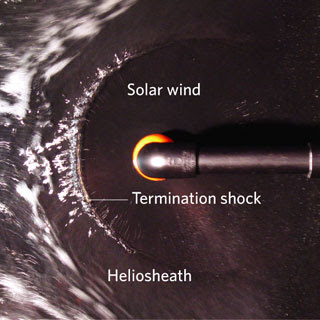

Gran parte de la investigación reciente se esta realizando en la Heliosfera. Este es el nombre que se le da a la región espacial que se encuentra bajo la influencia del viento solar, que se compone de iones procedentes de la atmósfera solar. Esto da origen a una burbuja en cuyo interior se encuentran los planetas de nuestro Sistema Solar. El límite que impone la burbuja se llama heliopausa (Heliopause). La capa que separa a la heliopausa del frente de choque de terminación se llama heliofunda (Heliosheath).

Viajero 2 ha realizado múltiples cruces con la heliofunda, esto se presume es debido a los cambios dinámicos de la onda de choque (movimientos rápidos al interior y exterior, re-formación de la onda), efectos similares a los que podríamos ver en una llave de agua de cocina, solo como analogía, en este el agua es radiada de un punto, similar al fenómeno de radiación del Sol. Entonces el agua forma una onda de choque envolvente casi-circular, y si añadimos, un medio de flujo uniforme representado por agua jabonosa proveniente de la izquierda, se asemejaría a la interacción del Sol con el espacio interestelar [2]. Ver figura siguiente.

Las observaciones de los viajeros han corroborado la existencia de esta onda de choque, la cual al parecer es muy compleja en sus interacciones. Además, ha establecido una nueva perspectiva en nuestra visión de la interacción del Sol con la Galaxia.

Referencias:

[1] Jokipii, J., A shock for Voyager 2, Nature, Vol.454, July 2008.

Videos:

Video revista Nature: http://www.nature.com/nature/videoarchive/voyager/

Monday, June 9, 2008

¿Que paso antes del origen del universo?

La teoría de la gran explosión ha sido considerada por los científicos como el mejor modelo para explicar el inicio del universo, utilizando la teoría de la relatividad general de Einstein y extrapolando el tiempo y la expansión del universo hacia atrás, se llega a que el nacimiento del universo sucedió hace aproximadamente 13.7 mil millones de años a partir de una “singularidad” que consiste de un punto de volumen igual a cero pero al mismo tiempo con densidad y energía infinitos.

La teoría de la “gran explosión” (Big Bang), ha sido exitosamente confirmada por varias observaciones independientes, por ejemplo, el corrimiento al rojo de las galaxias es el resultado de la expansión del universo, la radiación de fondo, que es radiación cósmica de microondas existente en todo el universo, provee evidencia de que debido a la expansión, el universo se ha enfriado naturalmente a partir de densidades y temperaturas extremas al inicio. La abundancia de los elementos ligeros, Hidrógeno y Helio en el universo, se ajusta casi perfectamente a las predicciones calculadas provenientes del la teoría de núcleosíntesis en la gran explosión.

Sin embargo, existen misterios del universo que no son explicados por el modelo de la gran explosión. Una de las fallas encontradas al modelo es que lo que paso durante la gran explosión no puede ser derivado de la teoría pues existe un punto en el tiempo a partir del cual deja de ser válida, este punto es el tiempo de Planck (10-43 seg.) y ha sido una barrera en los intentos científicos de entender el origen de nuestro universo en expansión. La singularidad esta en total contradicción con el principio de incertidumbre, fundamento de la física cuántica, ya que según este, no es posible una densidad infinita. Así, la singularidad al inicio del universo parece ser una limitación de la teoría de relatividad general más que un inicio físico del universo [1].

El físico mexicano Alejandro Corichi, investigador del Instituto de Matemáticas de la UNAM , en colaboración con investigadores del "Institute for Gravitation and the Cosmos" perteneciente a la Universidad estatal de Pennsylvania en Estados Unidos, y del "Perimeter Institute for Theoretical Physics" en Ontario, Canadá, han propuesto que en lugar de la gran explosión lo que ocurrió fue un “gran rebote” (Big Bounce) [2].

Los investigadores desarrollaron una herramienta matemática llamada “Loop quantum gravity”[3] que combina relatividad general con física cuántica, esta teoría predice que en su origen, nuestro universo tenia un volumen que no es cero y una energía que no es infinita, con lo cual, las ecuaciones de la teoría producen resultados matemáticos válidos durante y antes de la gran explosión, abriendo así una ventana en el tiempo que permite mirar antes del gran rebote, concluyendo que nuestro universo es el resultado de un universo anterior que se colapsó y dio origen al nuestro.

Aunque la idea de un universo oscilatorio o de un modelo cíclico de universos no es nueva, Alejandro Corichi, en su artículo publicado en Physical Review Letters en abril del 2008, no solo resuelve exactamente el primer modelo matemático que establece la existencia de un gran rebote sino que va mas allá y demuestra que, dentro de su modelo, existen propiedades del universo anterior que fueron retenidas después de ocurrir el gran rebote y que se conservan en nuestro universo. El modelo utilizado es muy simplificado pero el hecho de que sea el primero en su tipo que es posible resolverlo exactamente da a los científicos oportunidad de buscar observables que sean predichas por la teoría, así como derivar propiedades y características del universo anterior.

Referencias

[1]M. Bojowald, Nature Physics 3, 523 - 525 (2007)

[2]A. Corichi and P. Singh, PRL 100, 161302 (2008)